#pip install Appium-Python-Client==2.6.1

#selenium 4.11.2

from appium import webdriver

from selenium.webdriver.common.by import By

from time import sleep

#设置设备信息

desired = {

"platformName": "Android",

"platformVersion": "5.1.1",

"deviceName": "VOG-AL10",

"appPackage": "com.android.browser",

"appActivity": "com.android.browser.BrowserActivity"

}

#设置appium的服务

server = 'http://localhost:4723/wd/hub'

# 新建一个driver

driver = webdriver.Remote(server, options=desired)

#蒙版元素,需要点击一下

value = '/hierarchy/android.widget.FrameLayout/android.widget.FrameLayout/android.widget.FrameLayout/android.widget.LinearLayout/android.widget.FrameLayout[2]/android.widget.LinearLayout/android.widget.FrameLayout/android.webkit.WebView'

driver.find_element(By.XPATH,value).click()

sleep(1)

#定位输入框

input_text = '/hierarchy/android.widget.FrameLayout/android.widget.FrameLayout/android.widget.FrameLayout/android.widget.LinearLayout/android.widget.FrameLayout[2]/android.widget.LinearLayout/android.widget.FrameLayout/android.webkit.WebView/android.webkit.WebView/android.view.View[2]/android.view.View[3]/android.view.View/android.widget.EditText'

input = driver.find_element(By.XPATH,input_text)

#输入内容,清空数据

input.clear()

input.send_keys('音乐')

sleep(1)

#定位按钮

button_text = '/hierarchy/android.widget.FrameLayout/android.widget.FrameLayout/android.widget.FrameLayout/android.widget.LinearLayout/android.widget.FrameLayout[2]/android.widget.LinearLayout/android.widget.FrameLayout/android.webkit.WebView/android.webkit.WebView/android.view.View[2]/android.view.View[3]/android.view.View/android.widget.Button'

button = driver.find_element(By.XPATH,button_text)

#点击按钮

button.click()

sleep(1)

#com.android.browser/.BrowserActivity

启动报错:

Traceback (most recent call last):

File "d:\python\spiderProject\移动端爬虫\appium的实战.py", line 21, in <module>

driver = webdriver.Remote(server, options=desired)

File "D:\virtualenv\spider_env\lib\site-packages\appium\webdriver\webdriver.py", line 230, in __init__

super().__init__(

TypeError: WebDriver.__init__() got an unexpected keyword argument 'desired_capabilities'

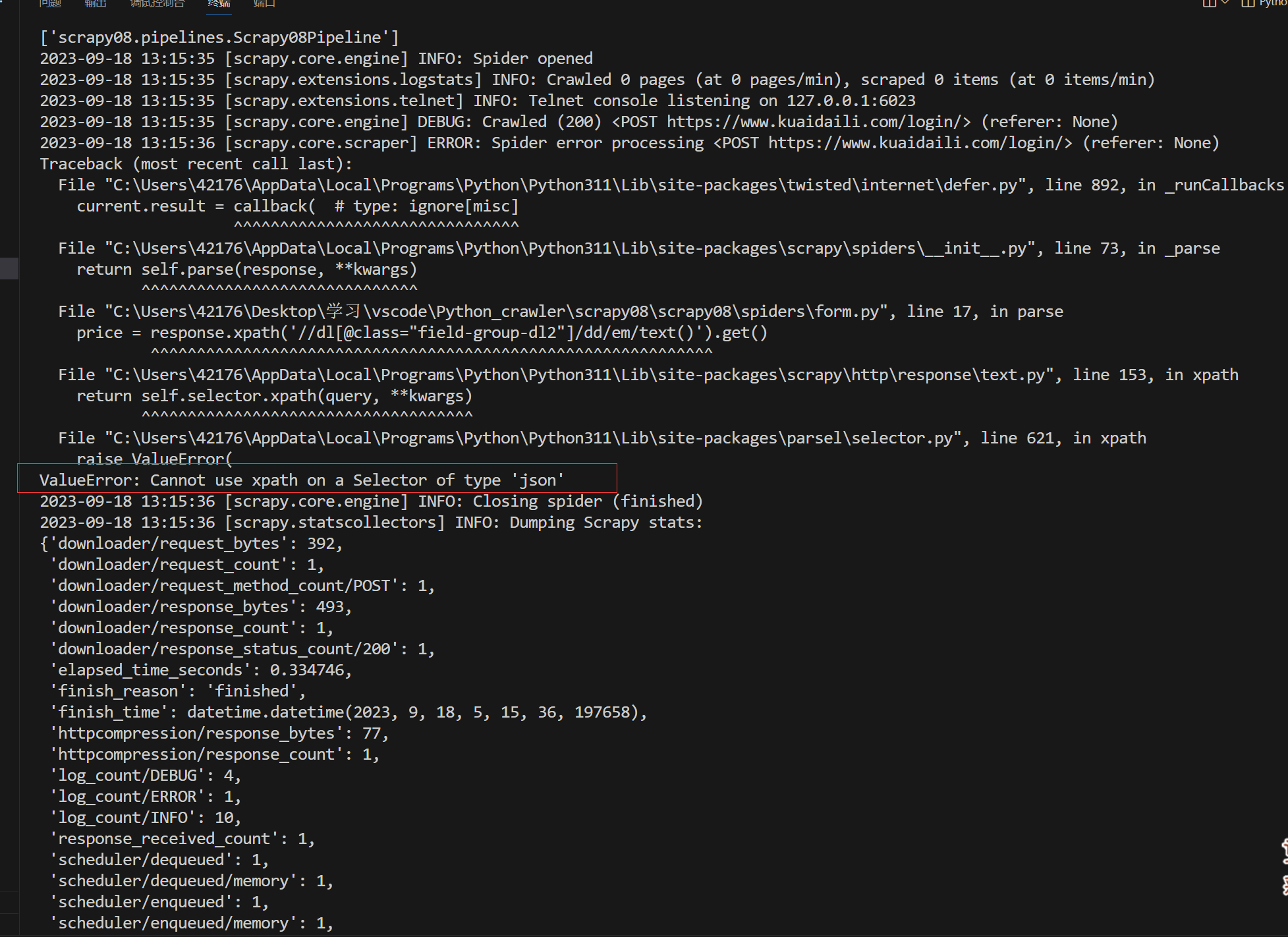

请问报错:无法在json类型的选择器上使用xpath,是什么意思?

请问报错:无法在json类型的选择器上使用xpath,是什么意思?